現地時間5月14日、米Googleは年次開発者会議 「Google I/O 2024」 を開催。同イベントの基調講演のなかで 「Project Astra」 を発表した。

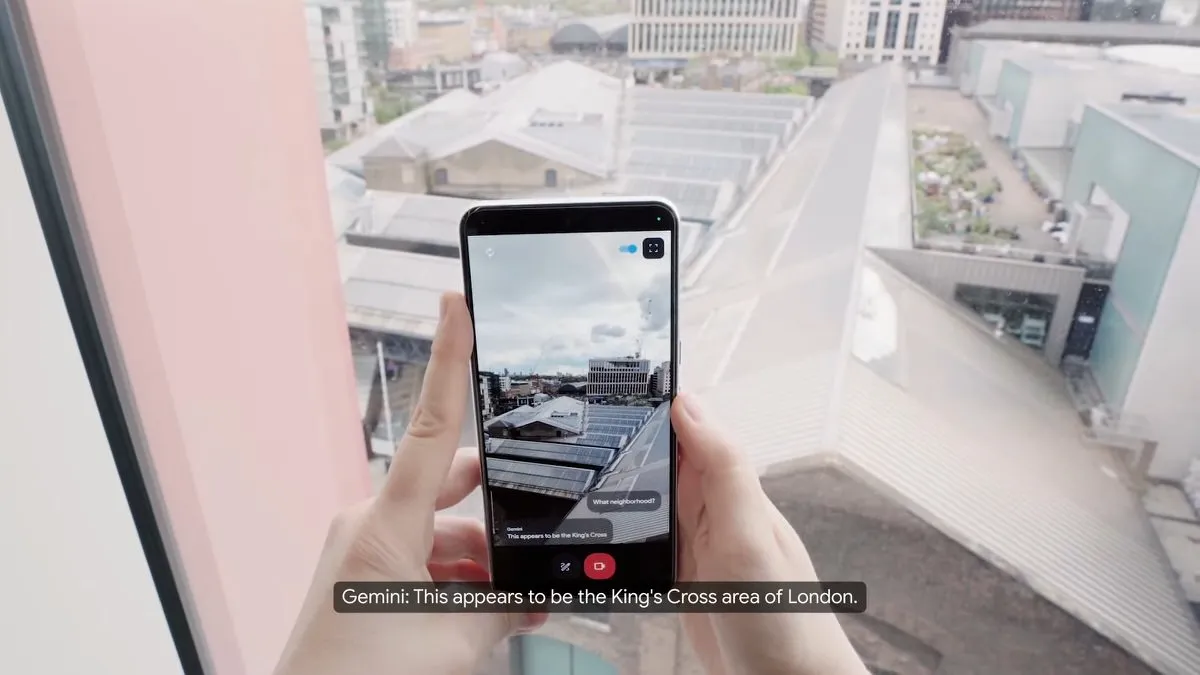

「Project Astra」 は、Googleが手掛ける新しいマルチモーダルAIモデル。スマートフォンのカメラで撮影した風景や、音声による質問に対してAIがリアルタイムで推論し回答することができる。以下がそのデモンストレーション動画だ。

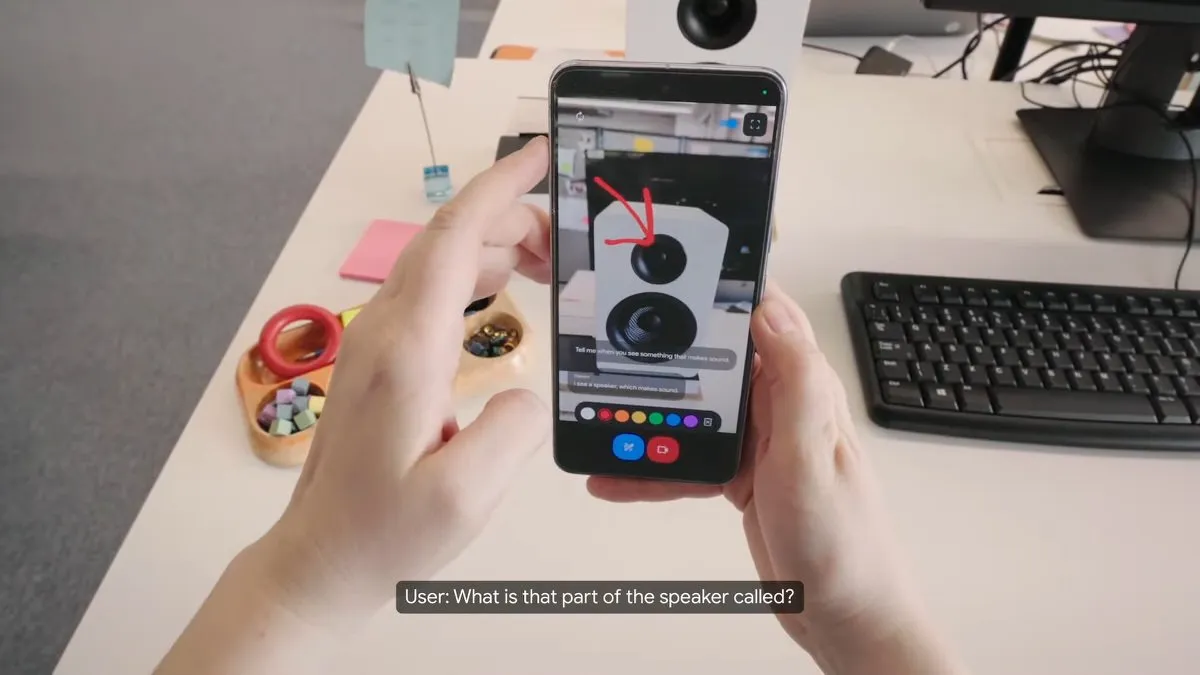

映像のなかで何が映っているかを回答させたり、スピーカーの部分の名称を聞いたり (ツイーターと正確に回答) 、ディスプレイに映るコードから、それが何をするためのコードなのかを分析させたり。外の風景を写し、ここがどこなのか推論させたり。さらには、どこにメガネを置いたのか探させたりもできるようだ。一度フレームアウトした光景なのにも関わらず、AIはどこにメガネがあったのか覚えていたことになる。

Googleは、この生成AIモデルをカメラを内蔵したスマートグラスに実装することで、より高い効果を発揮すると言いたげだ。

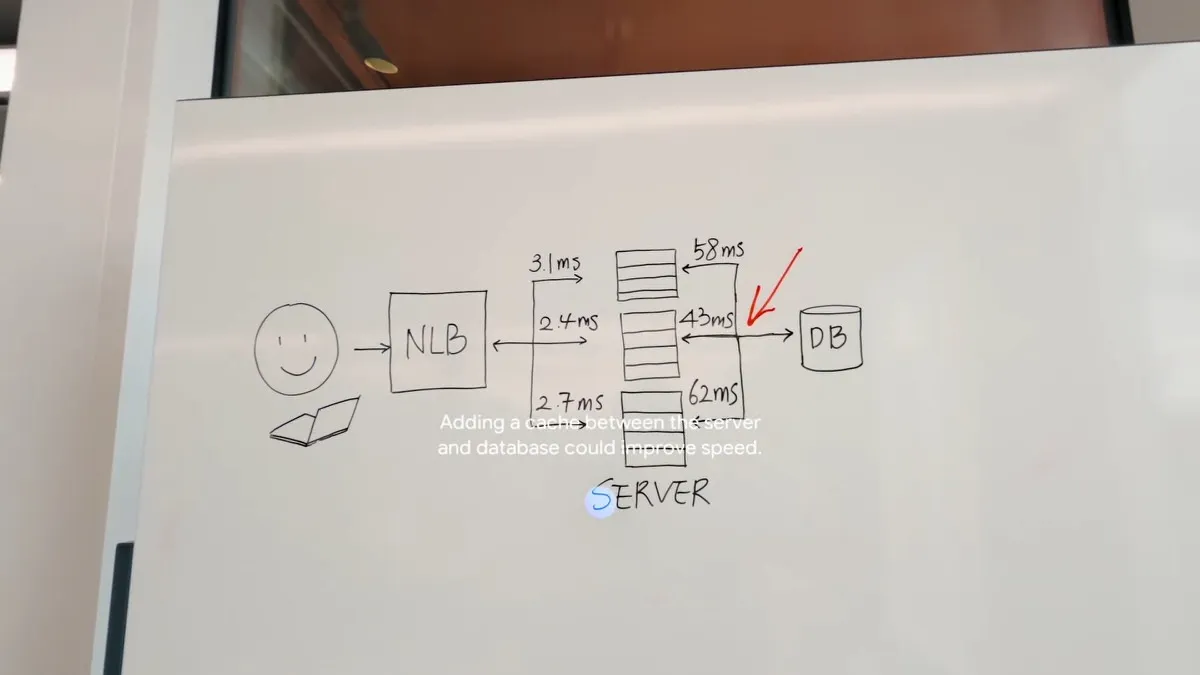

たとえば、スマートグラスのカメラを通してホワイトボードの図を分析し、改良方法を推論させようとした。AIは、「サーバーとデータベースの間にキャッシュを追加することで速度が向上します」 と回答してみせた。

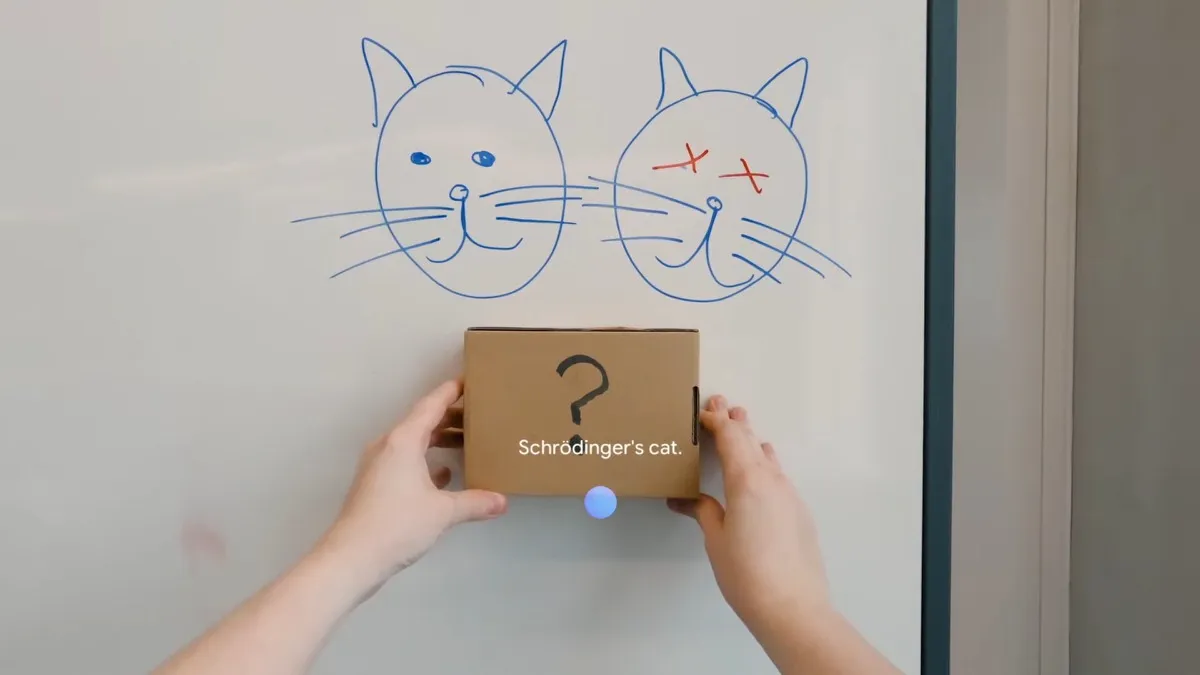

また、ホワイトボードに描かれた2匹の猫から 「何を連想させるか」 と聞いたところ、「シュレディンガーの猫です」 と回答した。さらに、虎のぬいぐるみをゴールデンレトリバーの隣に置き、「このデュオのバンド名は?」 と尋ねたところ、「ゴールデンストライプス」 と自ら考え、回答した。

スマートフォンのカメラで見せるよりも、ウェアラブルのほうがより自然に利用でき、相性が良いということなのだろう。デモンストレーションでは、AIは人間とのやりとりと同等の速度で回答しており、装着者の思考を途切れさせることなく会話することができていた。

実際いつこのAIが利用できるようになるのかについては発表されていないが、将来的にスマートフォンやスマートグラスを通じて、これらのAI機能が利用できるようになることを目指しており、また今年後半にはこのAI機能の一部がGeminiアプリのようなGoogle製品に実装する予定としている。

(画像:Google)