Appleは現地時間6月10日、毎年恒例の年次開発者会議 「WWDC24」 の基調講演を開催した。発表の内容は例年どおり次期OSに関するものが大半だったが、基調講演の最後で以前から噂されていた 「AI」 に関する取り組みが紹介された。

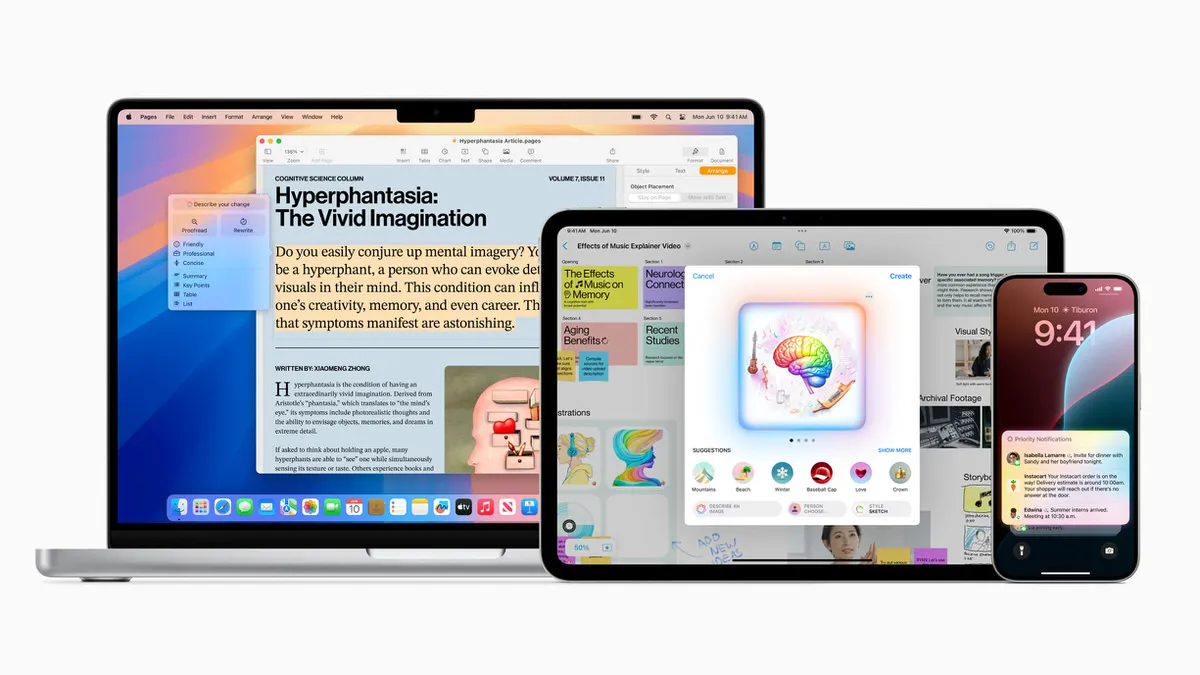

発表されたのは 「Apple Intelligence」 。iPhoneやiPad、Macの各OSにネイティブ実装し、OS全体でAI機能を活用できるようにするというものだ。詳細は別記事で書いているためぜひそちらを参照していただきたいが、自社製品への生成AIの導入について他社に遅れを取っているAppleが、はじめて独自の生成AI機能を披露する場となったことから、今回の基調講演におけるメインの発表は 「AI」 だったと言える。

実際、Appleは基調講演全体のうち4割近くの時間をこの 「AI」 に割いていた。このことから、昨年の空間コンピューティングと同じくAI分野に対しても本気で取り組んでいることが感じられた。

一方で、ユーザー間で話題になっているのは 「Apple Intelligence」 そのものではなく、OpenAI社の 「ChatGPT」 との連携の話だったように感じている。

各OSに 「ChatGPT」 へのアクセスを組み込むことで、SiriがChatGPTの持つ広範な知識から精度の高い返答を返したり、「ChatGPTアプリ」 を開かずともChatGPTとの対話を始められる。主流のAIチャットボットのひとつであるChatGPTにすぐにアクセスできる。これは確かに便利だ。

ただし、勘違いしてはいけないのは 「ChatGPT」 はAppleのOSにビルトインされるものの、AppleのAI機能のすべてが 「ChatGPT」 で動作するというわけではないということ。

「Apple Intelligence」 はChatGPTをベースにしたAIではない

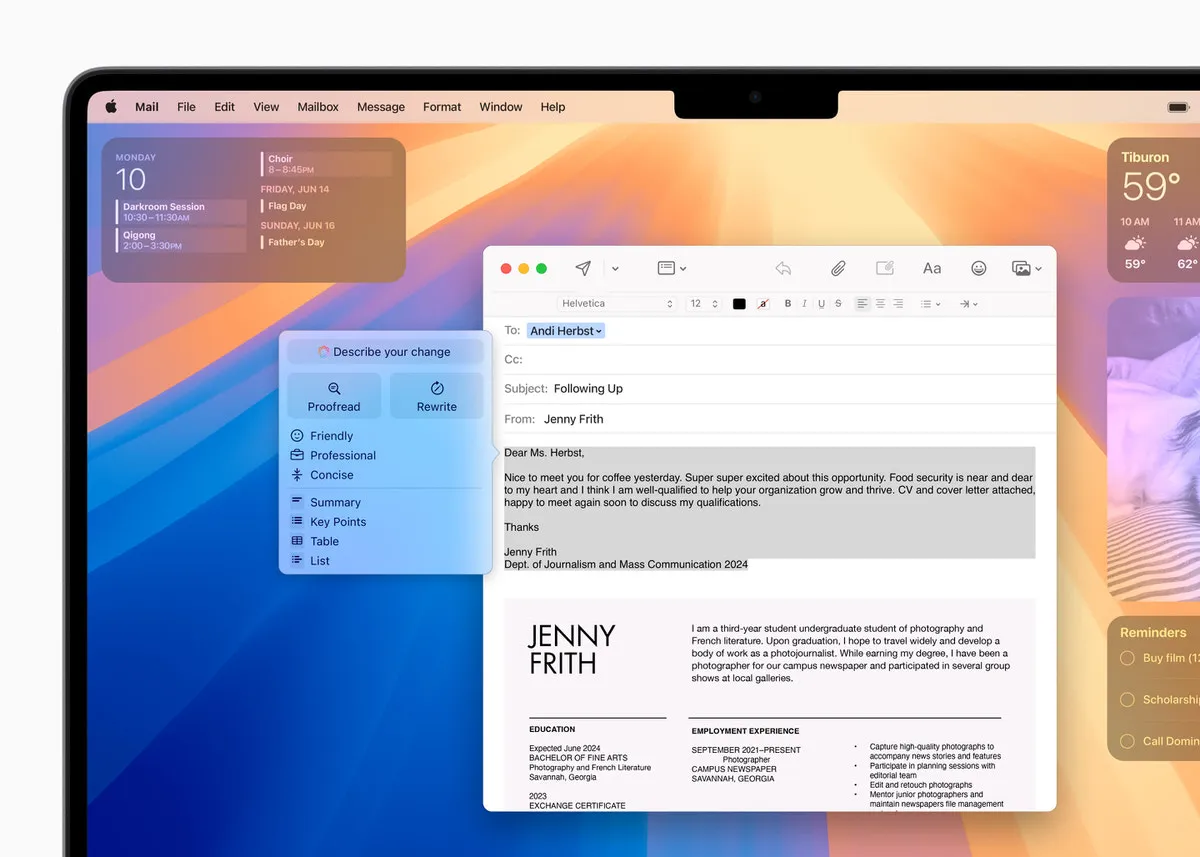

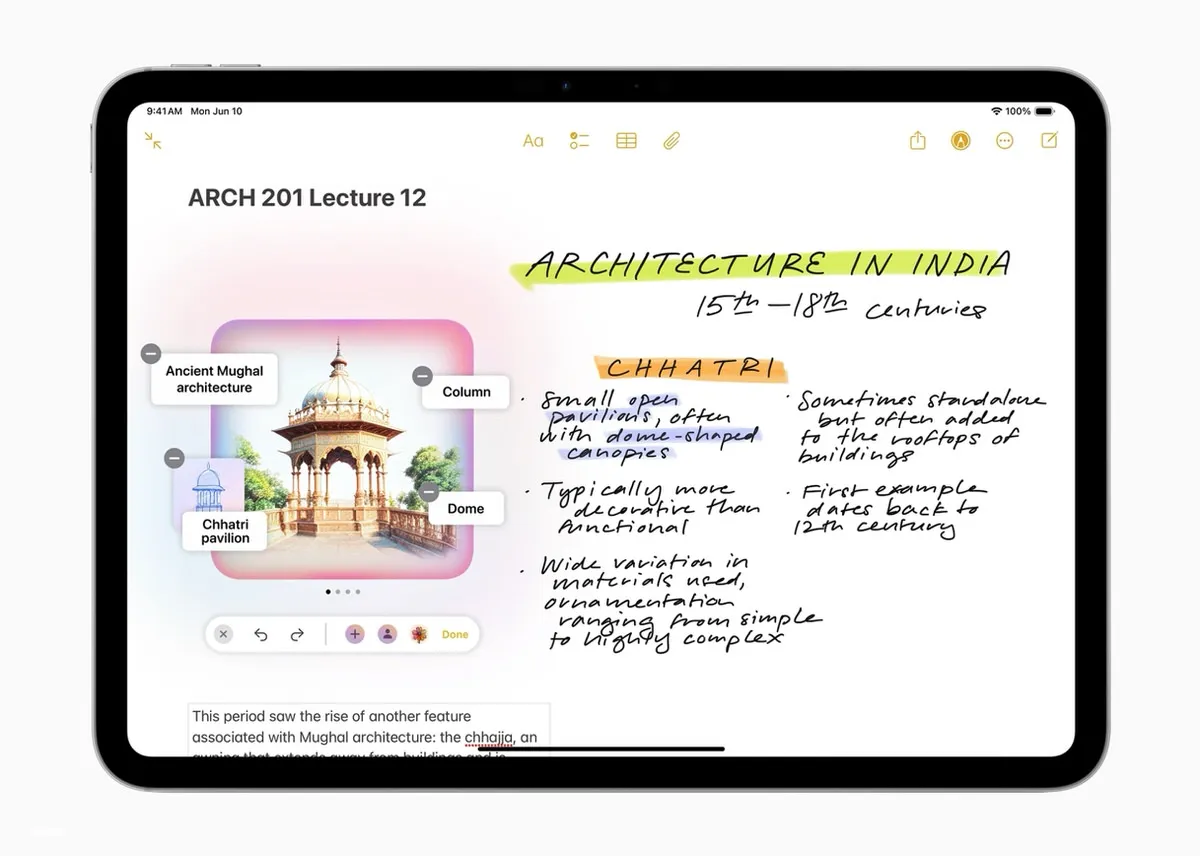

たとえば、基調講演で発表されたメールやメモアプリにおいて、テキストの作成や校正、要約をさせたり、 「Image Playground」 を使って画像を生成させたり。録音データから文字の書き起こしをさせたり、Genmojiを作り出すこともできる。これらはすべてAppleの独自のAI技術を利用したもので、OpenAI社の力は借りていない。

しかし、ユーザーからはこんな指摘がある。「こんな機能は他の生成AIでもできる」。確かにその指摘はごもっともだ。

先に言っておくと筆者はApple擁護派ではなく、生成AIはそれぞれの特徴があるため、今回のAppleの 「Apple Intelligence」 はかなりフラットな目線で見ている。そもそもまだ実際に動作している様子を見ることができていないため、他社のAIサービスに比べてどうなのかを推し量ることもできていない。

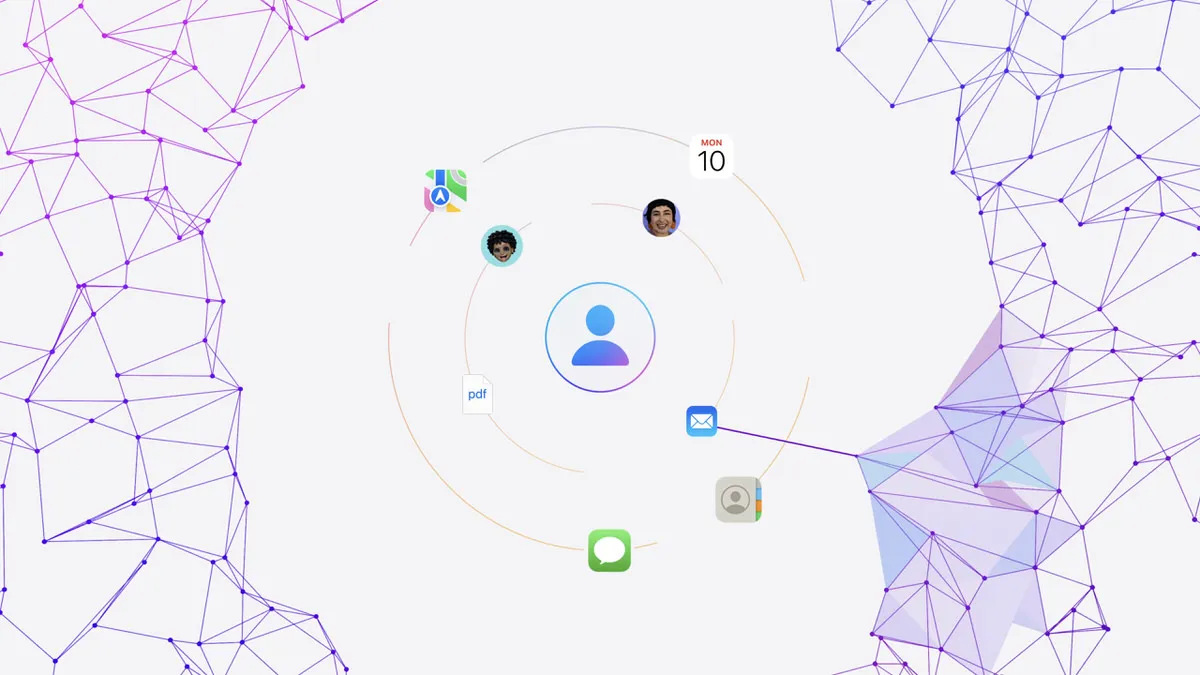

ただし、「Apple Intelligence」 の良さはプライバシーに対する確かな配慮と、OS全体に統合されることで起こるシームレスなLLM体験、これは掛け値なしに良いと思えた。

前者に関しては、個人情報の取り扱いに慎重なAppleならではの取り組みだろう。まず 「Apple Intelligence」 のAI機能は基本的にオンデバイスで処理するように作られている。

現行のAIの多くがクラウド型を基本としているなか、端末側で処理するというのであれば、通信は必要なくレスポンスも早められる。そして何よりも外部にデータを持ち出す必要がなく安心だ。

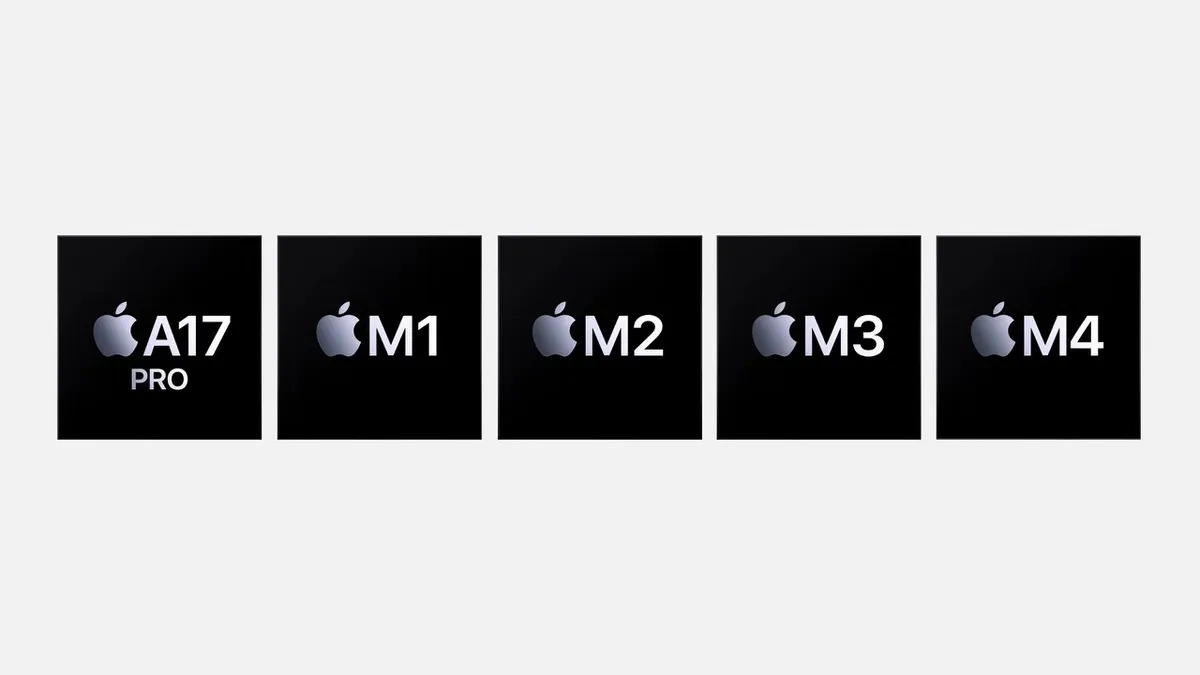

しかし、処理の内容によってはSoCのパワーが足りず (特にiPhone 15 Proに入っているA17 Pro) オンデバイスで処理できない、ということもあるだろう。そこでAppleは、負荷が大きい処理の一部をAppleのサーバーで行うことを考えた。

「Private Cloud Compute」 という技術を用いてこれを実現する。これは、オンデバイスで実行しきれない複雑な処理を、Appleシリコンで稼働するサーバーに情報を渡して処理させるというもの。ひとつひとつの命令がそれぞれプライベートな形で処理される上に、処理が終わったデータはサーバーから消去される仕組みになっているため、仮にインターネットを介してデータをやりとりしたとしても、AI処理に使われたデータについてAppleが知る術はない。

前述のオンデバイス処理と 「Private Cloud Compute」 を併用することで、ユーザーのプライベートな情報を担保するというわけだ。

他社の生成AIでもプライバシーに関わる処理はオンデバイスで行う仕組みが活用されているケースもあるものの、Appleはプライバシーを最も重視する会社ということもあり、この辺りに抜かりはないようだ。

後者については別記事でも触れたとおり。デバイスの中に入っている情報や、生成AIとのやりとりのなかで生まれた文脈 (コンテキスト) から、ユーザーが欲している情報を深く理解し、返答することができる。GoogleのGeminiやChatGPTはあくまでもチャットボットで入力された質問 (プロンプト) に対してどういう答えを返すかが基本的に求められるが、「Apple Intelligence」 の場合はよりパーソナライズされた答えを返すことができる。

具体的なユースケースとして例に挙げられていたのが、会議の開始時刻が変更されて娘の演劇発表会に間に合うかわからないとき。「Apple Intelligence」 はユーザーの娘が誰なのか、そして娘が数日前に送ってきた発表会の詳細、そして会議の場所と時間、周囲の交通状況のトラフィックを予測し、娘の演劇発表会に間に合うか、ざっくりと計算してくれる。もしこれがさまざまな場面で活用できたなら、「Apple Intelligence」 は真のAIアシスタントとして評価されるはずだ。

では、なぜそんな立派な生成AIを作り出せたのに 「ChatGPT」 との連携が必要だったのか。

まずは、オンデバイス向けのAIでは 「ChatGPT」 のようなクラウド型の大規模言語モデルのようなことができないことが挙げられる。「Apple Intelligence」 はあくまでエッジ型のAIであることから、それを補うために 「ChatGPT」 との連携が必要になったということだ。

本来であれば、Appleが自ら 「ChatGPT」 のようなLLMを作り出すことができるのが理想だ。ただし、「ChatGPT」 は高い精度で回答を作り出すことができるが、一方でたまに嘘をつく (間違った回答を出す) ことがあり、生成AIの技術はまだまだ不完全なものと言える。その 「ChatGPT」 にAppleの生成AIがクオリティで敵わなければ、自らのブランド力を損なう可能性も出てくる。

もちろん、時間をかければAppleも自前で 「ChatGPT」 のようなLLMを作り出すことはできるだろう。技術力も資金力も十分にある会社だ。

しかしながら、直接的なライバルとなり得るMicrosoftやGoogleが 「Microsoft Copilot」 なり 「Gemini」 なりをすでに積極的に取り入れている現状を踏まえて、「強力な生成AIを持たないApple」 「生成AIに遅れを取っているApple」 という印象も市場に与えたくない。そこで、Appleは 「ChatGPT」 の手を借りるという手段をとったのではないだろうか。

「ChatGPT」 は、Microsoftの生成AI 「Microsoft Copilot」 で採用されているなど実績もある。また、「ChatGPT」 が犯すミスは厳密にはAppleの失態ではないという点も、安心できるポイントとも言えるかもしれない。

もちろんこれらは筆者の憶測で、そもそもAppleとしては 「ChatGPT」 のようなクラウド型のLLMを作る気がなかったのかもしれないが、その場合 「Apple Intelligence」 は外部サービスとの連携ありきで作られたことになり、市場をガッカリさせてしまっていた可能性もあった気がする。

「Apple Intelligence」 が、他社の生成AIに勝る性能を持っているかというとそうではない。むしろオンデバイス向けのAIということで 「Apple Intelligence」 が苦手とするものもある。「ChatGPT」 は、その 「Apple Intelligenceができないこと」 を補完する存在になるというわけだ。利用する際にはユーザーからの許可を取る形となり、知らないうちにChatGPTを利用してしまうことを防ぐ機能も搭載されている。

今回の基調講演を見る限り、「Apple Intelligence」 が目指す道は他社の生成AIサービスとはすこし異なり、OS全体にAIを浸透させることで新しいデバイス体験ができることをAppleは示したいのだと思えた。同じ 「AI」 ではあるものの、立つ土俵がそもそも違うのだろう。

生成AIについてはまだ出てきたばかりの技術で、今後さらに高度なトレーニングを積ませることでAIの技術はまだまだ進化していくはずだ。iPhoneやMacなどのデバイスもさらに高度なことができるようになっていくだろう。

そのファーストステップが、今回発表された 「Apple Intelligence」 だったということだ。まずはその出来がどれほどのものなのか、今年から提供が開始される米国英語環境で実際に利用して確かめてみたいと思う。

「Apple Intelligence」 に対応するSoC

「Apple Intelligence」 は各OSのベータ版 (米国英語環境) において今夏から試験提供が開始され、その後一般ユーザー向けには今秋にリリース予定の 「iOS 18」 「iPadOS 18」 「macOS Sequoia」 の米国英語環境においてベータ版として提供される予定となっている。

利用できるデバイスは、A17 Proチップ以降を搭載したiPhone (具体的にはiPhone 15 Pro/iPhone 15 Pro Max)、そしてM1チップ以降を搭載したiPad、Mac。

米国英語以外の言語においては2025年以降に提供予定。また、一部機能については米国英語環境においても2025年以降の提供となるようだ。

関連記事

・Appleの初の生成AI 「Apple Intelligence」 機能まとめ。テキスト・画像の生成、Siriが賢さアップなどの恩恵がAppleデバイスにもたらされる

Apple公式サイトで各種Mac製品をチェック

▼ ラップトップMac

・MacBook Air

・MacBook Pro

▼ デスクトップMac

・Mac mini

・24インチiMac

・Mac Studio

・Mac Pro

▼ Macアクセサリ

・Magic Keyboard

・Magic Trackpad

・Magic Mouse

・その他

▶︎ 学生・教職員向けストア

(画像:Apple)