5月7日(現地時間)、Googleは米マウンテンビューで年次開発者会議 「Google I/O 2019」 を開催。同イベントで 「Google検索」 の新機能を発表した。

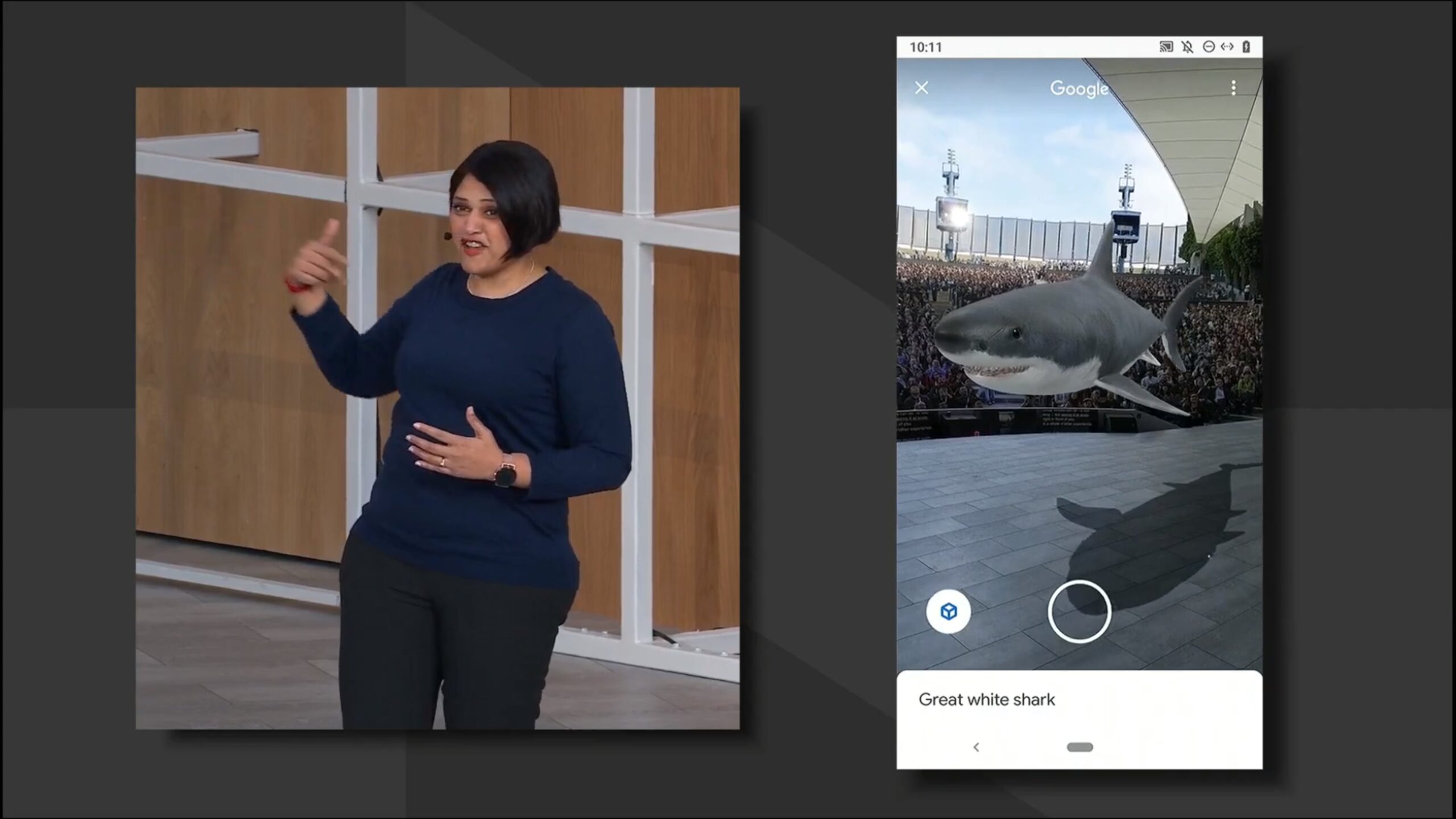

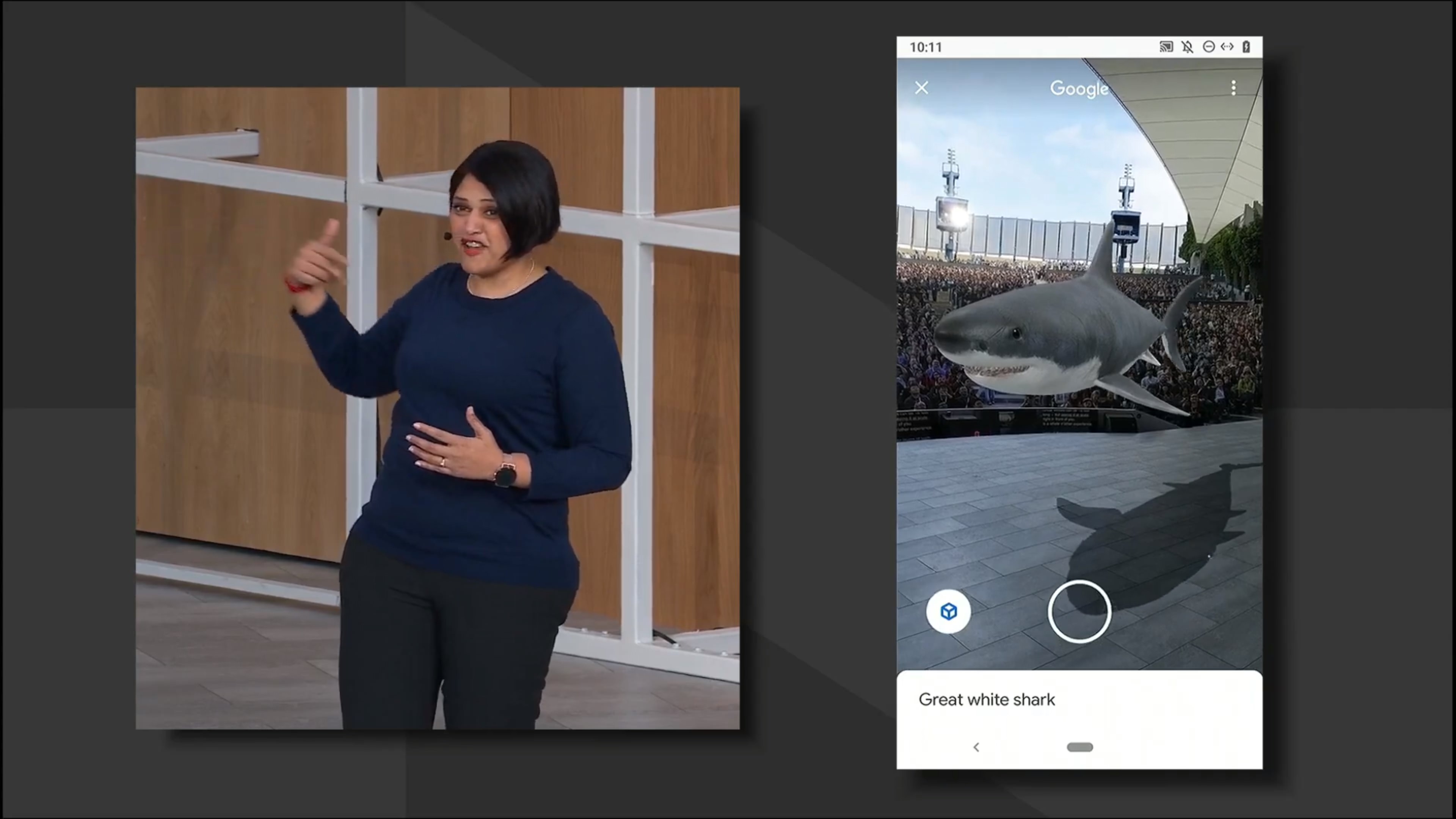

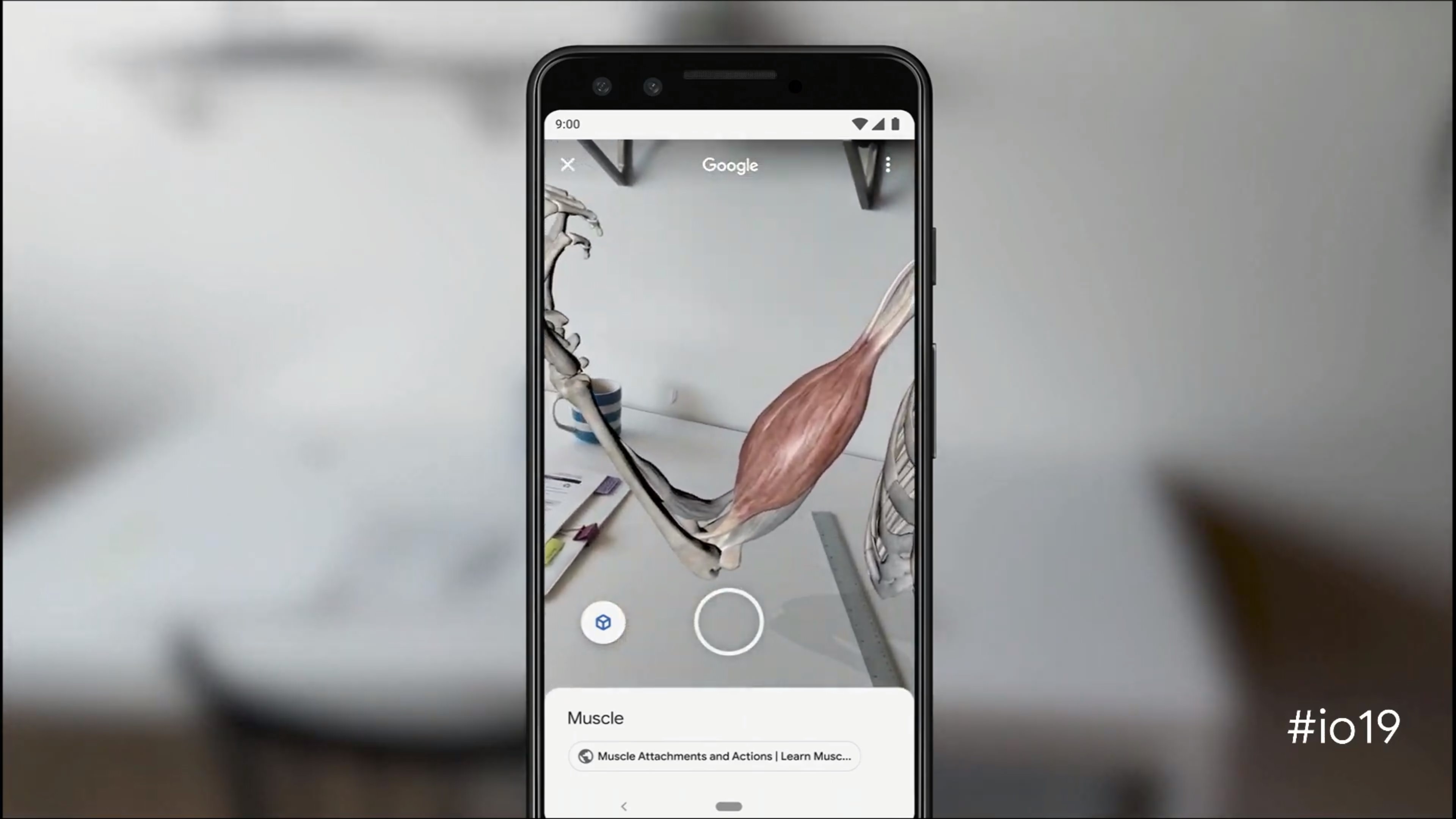

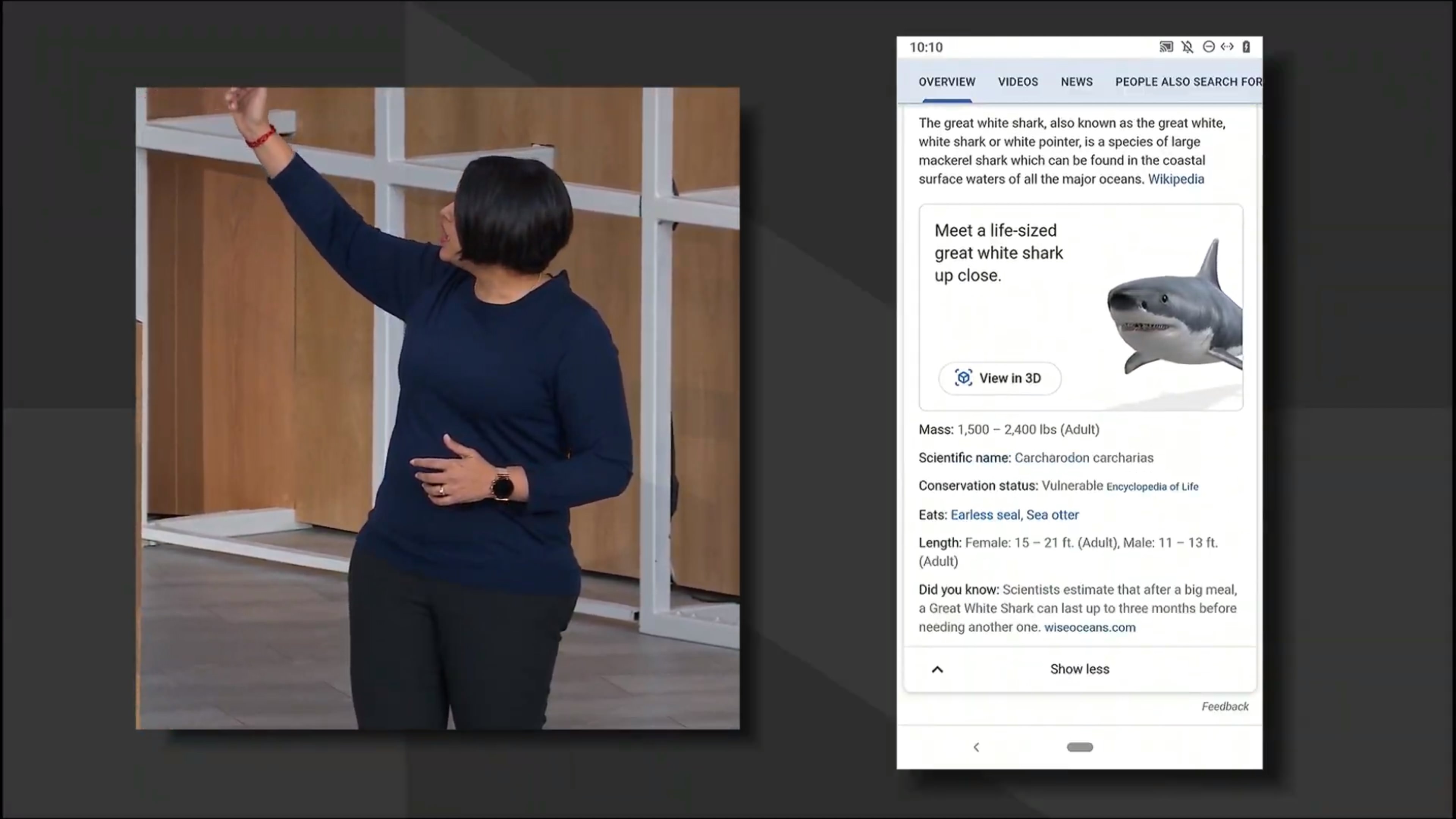

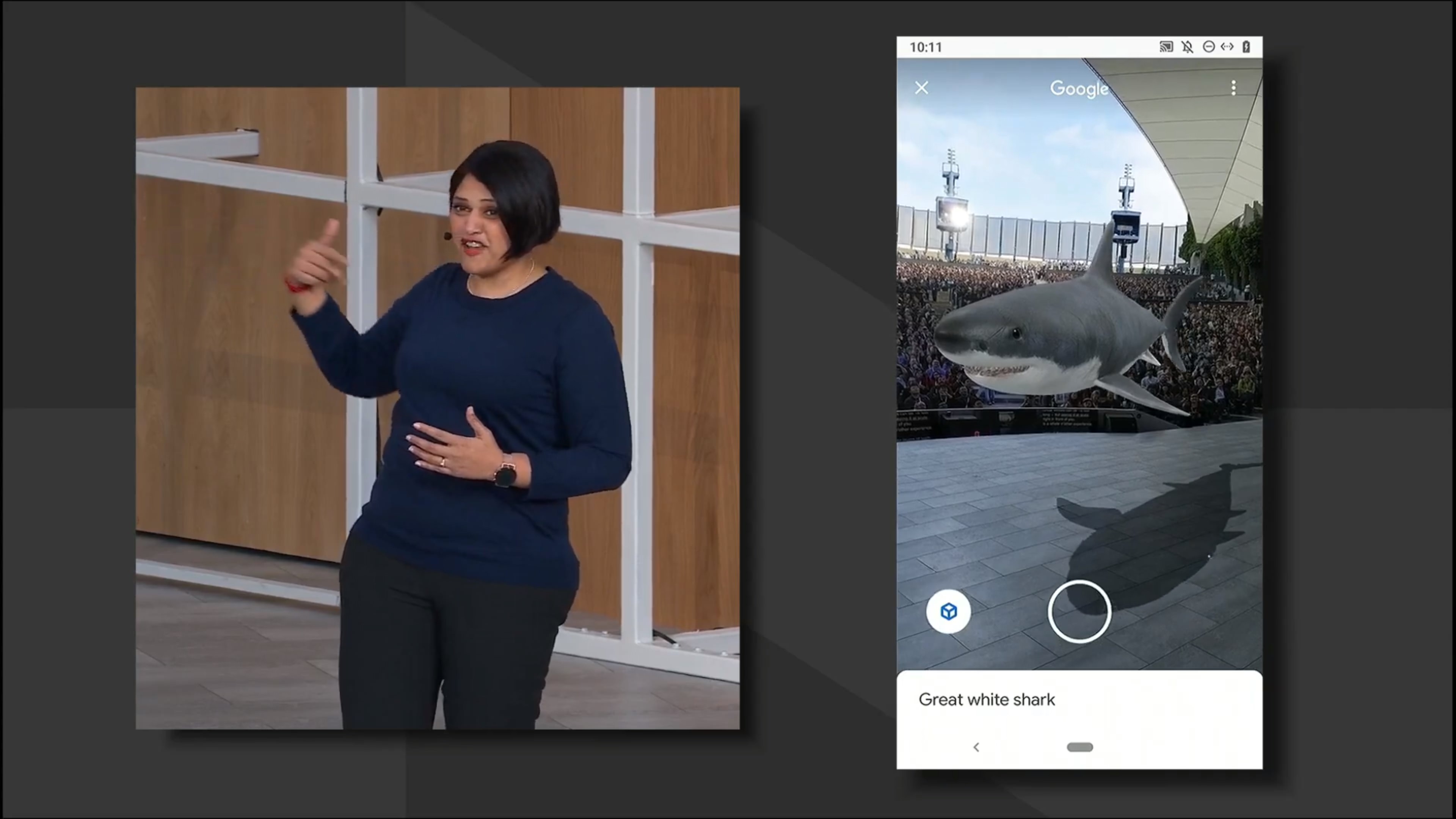

今回発表された新機能は、「Google検索」で検索したワードから3Dモデルを表示できるというもの。例えば、Google検索で 「筋肉」 と検索すると、サーチ結果に筋肉が表示され、その実物をスマートフォンのカメラ越しに見ることができる。3DモデルはARカメラを通してみることになるため、自宅に置いてある実際のモノと大きさを比較することもできる。

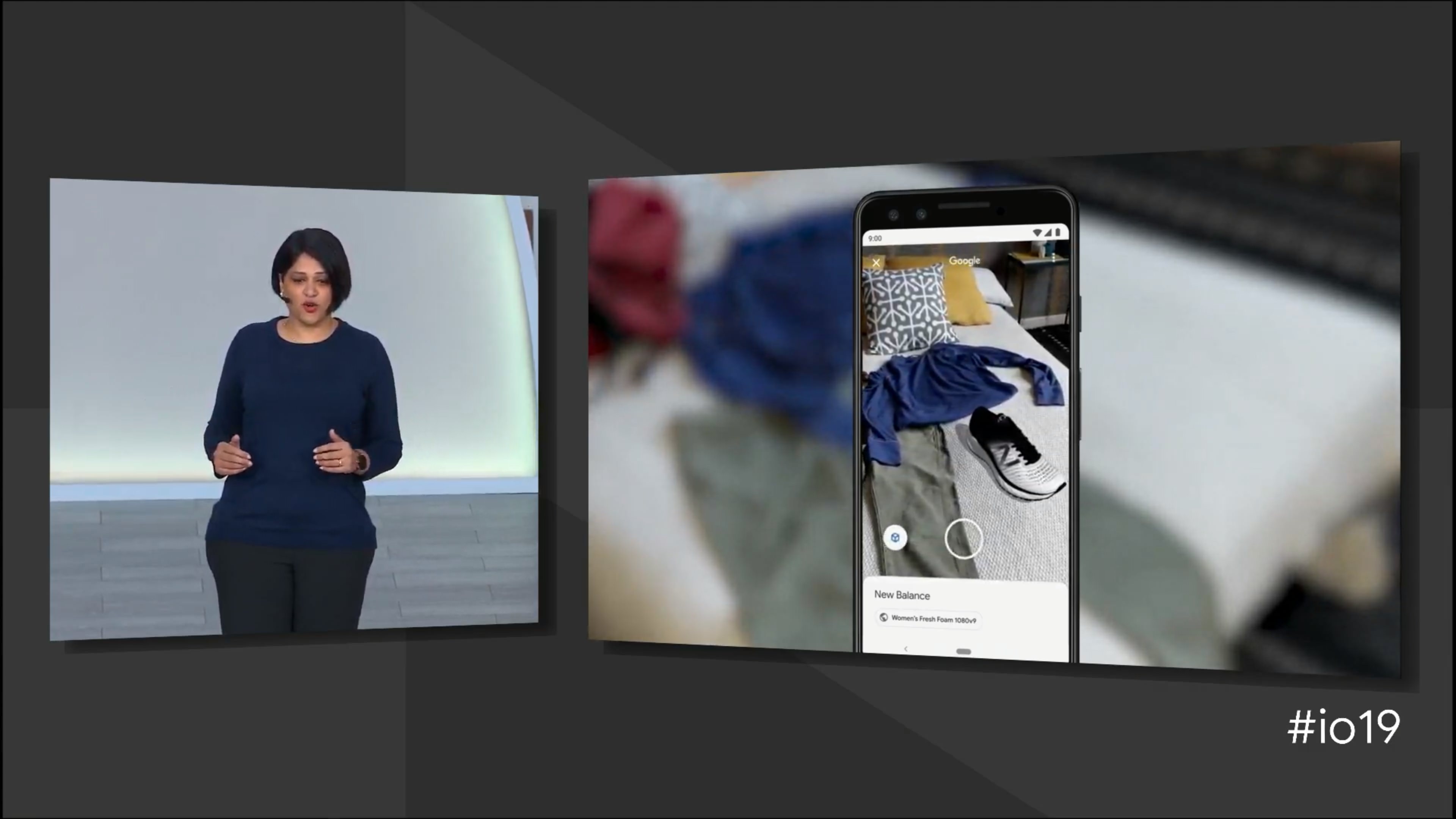

デモでは、巨大なホオジロザメを表示したり、気になるスニーカーなどを表示したりと様々な3Dモデルが表示できることをアナウンスしていた。スニーカーに関しては自身の持っている服と合うかどうかもチェックできる。文字で調べて頭でイメージするよりも実物をみた方が手取り早いため、実際に使う機会も多そうだ。

Google Lensにレストランで活躍する新機能追加

「Google Lens」 にも新機能が追加される予定だ。

追加されるのは、主にレストランなどで役立ちそうな機能。なんとレストランのメニューにスマートフォンのカメラをかざすと、その店のおすすめメニューが表示されるというものだ。

Today’s special: Google Lens. 🍽️ Automatically highlighting what’s popular on a menu, when you tap on a dish you can see what it looks like and what people are saying about it, thanks to photos and reviews from @googlemaps. #io19 pic.twitter.com/5PcDsj1VuQ

— Google (@Google) 2019年5月7日

また、書かれているメニューがどんな料理なのかを写真で表示することも可能。海外に行くと知らない料理に出会う機会も多いが、実際に写真付きで確認できるようになるため、安心して注文することが可能になる。

さらに、食事をした後に貰うレシートから、チップを自動的に計算してくれたり、割り勘することも可能。とても便利だ。

Google Lensに翻訳テキストの読み上げ機能が実装

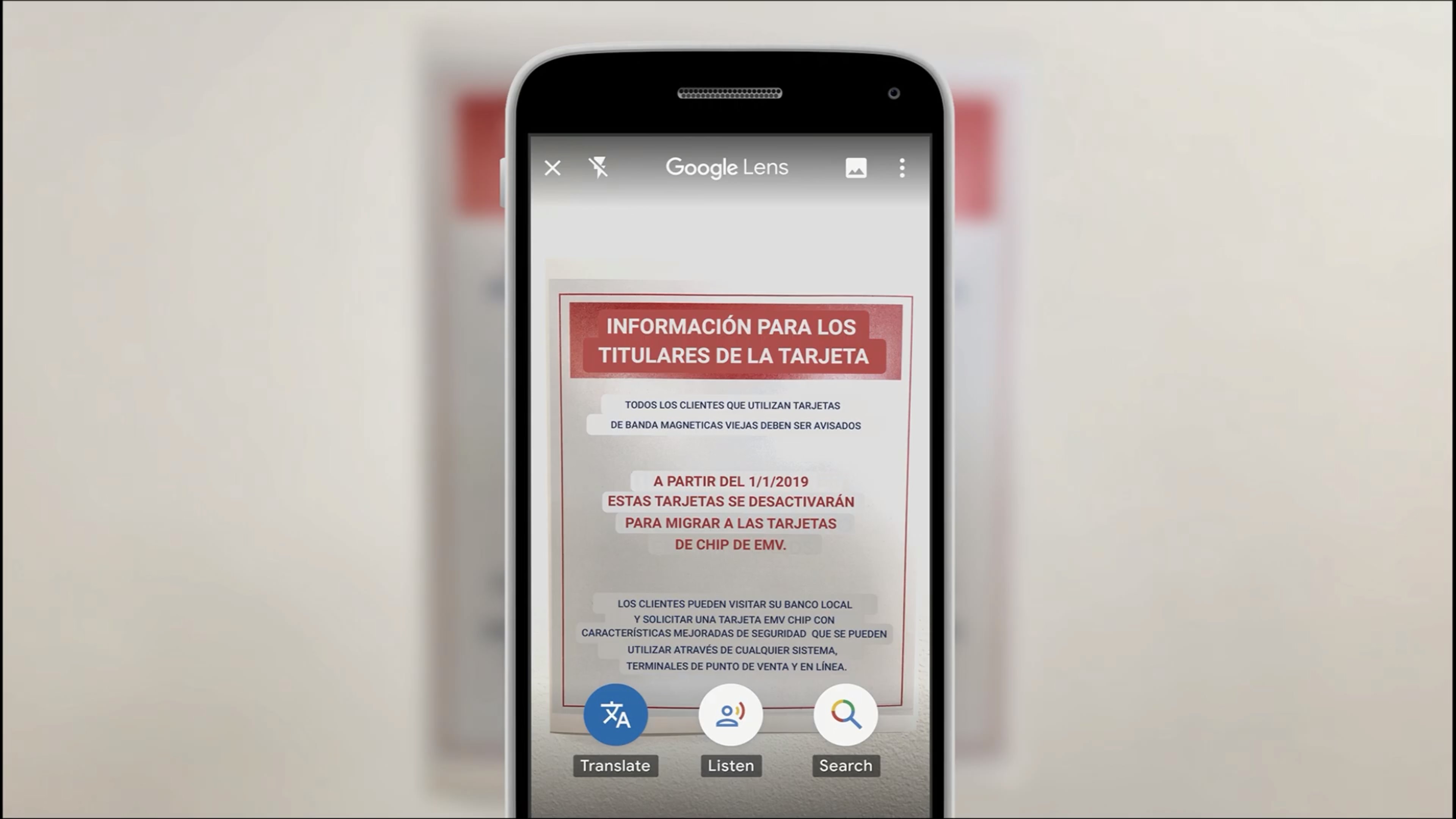

ちなみに、Google Lensはテキスト翻訳だけでなく、翻訳したテキストの読み上げにも対応する。例えば英語で書かれた看板を日本語に翻訳して読み上げ。英語が理解できずとも、何が書かれているのかを知ることができる。

Googleは同機能をそこまで性能が高くないエントリーレベルのスマートフォン (Google Go) でも利用できるように開発した。この機能が実装されることで、読み書きができない人でも標識や各種パッケージに書かれている文字を理解できるように。

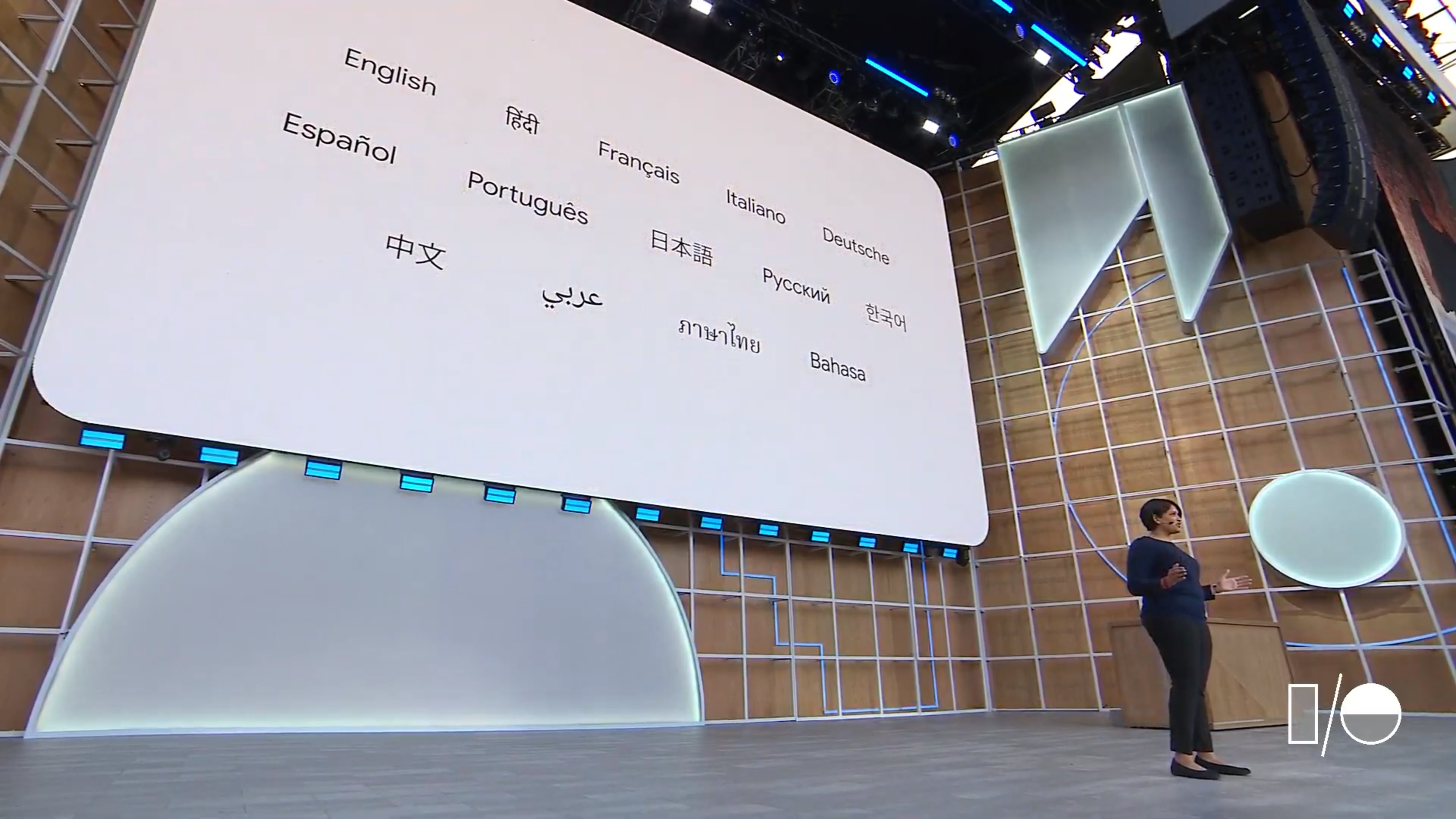

Googleはこの機能を 「Google Go」 向けに5月下旬リリース予定。対応言語は英語やフランス語、イタリア語、ドイツ語などの14ヶ国語、対応言語の中には日本語も含まれていると発表されている。